粗心學(xué)者忘刪ChatGPT痕跡慘遭撤稿!Nature痛呼AI論文太泛濫

本文來(lái)自微信公眾號(hào)“新智元”()作者:新智元

科研圈,快被生成的論文吞沒(méi)了!

8月9日,一篇收錄于

期刊上的論文,提出了一種復(fù)雜數(shù)學(xué)方程的全新解決方案。

論文地址:

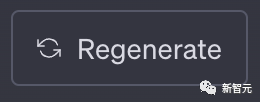

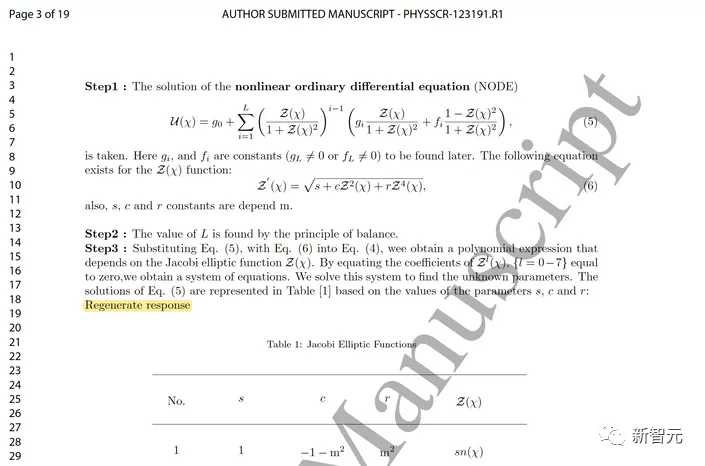

本來(lái)是皆大歡喜的事,直到科學(xué)打假人 在論文的第三頁(yè),發(fā)現(xiàn)了一處可疑的短語(yǔ)——「重新生成回復(fù)」( )。

經(jīng)常用的小伙伴chatgpt幫忙看論文,看到這個(gè)短語(yǔ),都會(huì)會(huì)心一笑。

「 」是網(wǎng)頁(yè)版上的一個(gè)按鈕,現(xiàn)在更新成了「」。

火速把這一發(fā)現(xiàn)po到了上,這也意味著,事情鬧大的話,這篇論文基本就被判死刑了。

果然,論文作者不得不承認(rèn),在寫作論文稿件時(shí)確實(shí)使用了。

論文的通訊作者為 ,他有兩個(gè)工作單位,一個(gè)是伊斯坦布爾的 ,一個(gè)是貝魯特的 。

這篇論文在5月被提交,7月發(fā)出了修訂版,在兩個(gè)月的同行評(píng)審期間,都沒(méi)有人發(fā)現(xiàn)其中的異常。

現(xiàn)在,

決定撤回這篇論文,理由是作者在提交論文時(shí),并沒(méi)有聲明自己使用了。

期刊的同行評(píng)審和研究誠(chéng)信主管Kim 表示,「這種行為違反了我們的道德政策。」

只是冰山的一角

然而,這篇論文,只是少數(shù)被曝光出來(lái)的「倒霉」選手。

從今年4月以來(lái),已經(jīng)「打假」了十幾篇論文,掛到了上。它們無(wú)一例外,都留下了的使用痕跡——「 」或「作為一個(gè)語(yǔ)言模型,我……」

所以,寫論文時(shí)究竟可不可以用呢?

對(duì)于這個(gè)問(wèn)題,(愛(ài)思唯爾)和 (施普林格·自然)在內(nèi)的許多出版商都有明確規(guī)定:大語(yǔ)言模型工具用是可以用的,只要作者聲明自己使用了即可。

不過(guò)目前看來(lái),大部分使用了的同行評(píng)審論文,都沒(méi)有聲明這一點(diǎn)。

已經(jīng)被逮到的論文,只是因?yàn)樽髡叽中模瑳](méi)有小心清除掉留下的痕跡而已。

只要作者足夠細(xì)心,用沒(méi)用,又有誰(shuí)能知道呢?

打假人表示,目前自己發(fā)現(xiàn)的論文,才只是冰山一角。

在愛(ài)思唯爾期刊中,他也發(fā)現(xiàn)了一些典型的「黑話」。

比如一篇8月3日發(fā)表在上的論文,主題是電子商務(wù)對(duì)發(fā)展中國(guó)家化石燃料效率的影響。

其中,就注意到,文章里有些方程完全就是不知所云。

不過(guò)最大的可疑之處在于,在某張表格上方,出現(xiàn)了這樣一行字:「請(qǐng)注意,作為一個(gè)語(yǔ)言模型,我無(wú)法生成具體的表格或進(jìn)行測(cè)試……」

對(duì)此,的一位發(fā)言人表示,他們已經(jīng)發(fā)現(xiàn)了這個(gè)問(wèn)題,正在對(duì)這篇論文進(jìn)行調(diào)查。

AI的大作,已經(jīng)完美混進(jìn)了人類作品

那么,一篇論文如果完全或部分由AI寫成,但作者不說(shuō),我們就沒(méi)有辦法發(fā)現(xiàn)了嗎?

大部分時(shí)候,的確如此。

最近美國(guó)南佛羅里達(dá)大學(xué)的一項(xiàng)研究表明,AI生成的文字內(nèi)容,可能已經(jīng)無(wú)法與人類寫的區(qū)分開(kāi)來(lái)了。

他們邀請(qǐng)了72名世界頂級(jí)語(yǔ)言學(xué)期刊的專家,要求他們來(lái)審查各種研究摘要,但即使是這樣的專業(yè)人士,也很難識(shí)別出哪些摘要是人寫的,哪些是AI寫的。

在62%的情況下,他們會(huì)被AI騙過(guò)去。

具體來(lái)說(shuō),每位專家都被要求檢查四份摘要,能全部正確識(shí)別出來(lái)作者是人還是AI的,一個(gè)都沒(méi)有。

甚至13%的專家,一個(gè)都沒(méi)做對(duì)。

專家們的識(shí)別依據(jù)是語(yǔ)言習(xí)慣和文體特征,盡管他們的分析頭頭是道、合乎邏輯,但總體的陽(yáng)性識(shí)別率也只有38.9%。

不過(guò)chatgpt幫忙看論文,英國(guó)科研誠(chéng)信辦公室的Matt 表示,有些論文也會(huì)包含一些微妙的痕跡,讓我們可以隱約發(fā)現(xiàn)的「身影」。

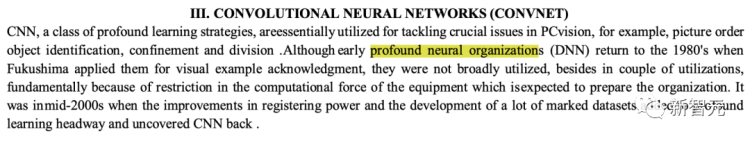

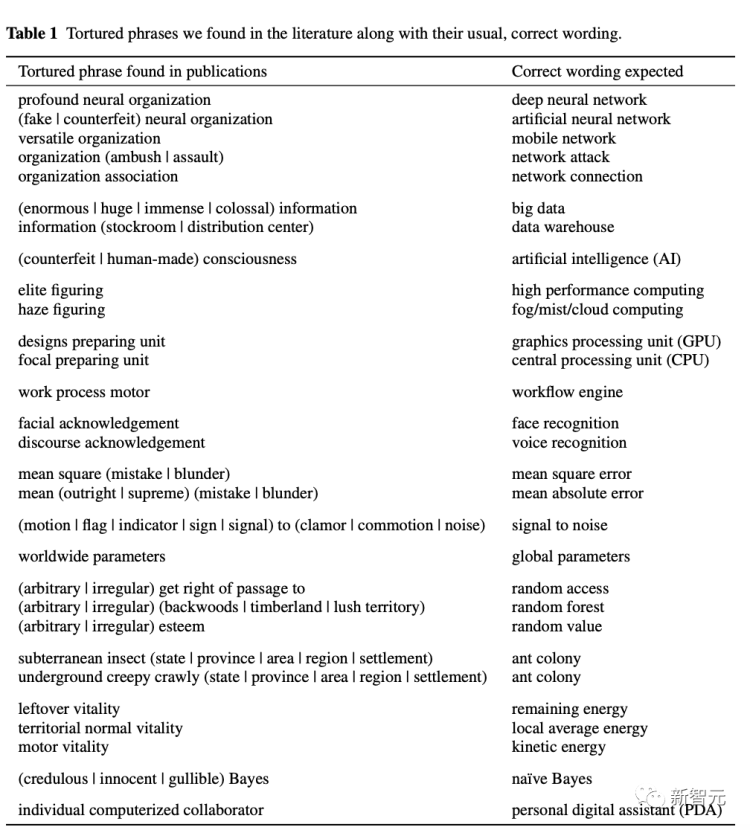

比如,一些常見(jiàn)于AI的特定語(yǔ)言模式,以及翻譯得怪里怪氣的「奇妙短語(yǔ)」。

此處淺淺地感受一下:深度神經(jīng)網(wǎng)絡(luò)—— (深刻神經(jīng)組織) 。

以及人工智能—— (仿制意識(shí)/虛偽意識(shí));大數(shù)據(jù)—— (巨信息);云計(jì)算—— haze (霾運(yùn)籌);GPU—— unit(設(shè)計(jì)準(zhǔn)備器) ;CPU—— unit(焦點(diǎn)準(zhǔn)備器)等等。

除此之外,AI在生成參考文獻(xiàn)時(shí)也是相當(dāng)?shù)摹柑祚R行空」,而這就可以作為同行評(píng)審時(shí)的重要參考。

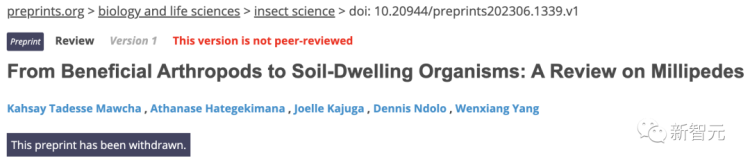

例如,(《撤稿觀察》)就曾揭露過(guò)一篇關(guān)于馬陸()的預(yù)印本論文是由編寫的。

在一位研究人員發(fā)現(xiàn)文章中引用的一篇「論文」竟然是自己寫的后,注意到了這里面提到的大量參考文獻(xiàn),都是假的。

類似的,丹麥國(guó)家血清研究所( )的微生物學(xué)家Rune 也遇到了AI偽造參考文獻(xiàn)的問(wèn)題。

當(dāng)時(shí),一名學(xué)生向AI聊天機(jī)器人尋求有關(guān)腸道寄生蟲(chóng)——芽囊原蟲(chóng)屬()的文獻(xiàn)建議,而這個(gè)聊天機(jī)器人則憑空編造了一篇以為作者的參考文獻(xiàn)。

于是,這位學(xué)生就去找了,表示希望能獲取這篇他發(fā)表于2006年的「論文」。

顯然,這篇論文根本就不存在。

然而,正如之前提到的,對(duì)于這些明顯會(huì)暴露論文使用了AI的痕跡,聰明的作者很容易就能把它們刪得一干二凈。

如此一來(lái),想要發(fā)現(xiàn)是否實(shí)用了AI,就變成了一個(gè)不可能的任務(wù)。

等打假人發(fā)現(xiàn),無(wú)論是同行評(píng)審的會(huì)議論文,還是未經(jīng)同行評(píng)審的預(yù)印本論文中,都存在大量使用了但未披露的情況。

當(dāng)這些論文被掛在上之后,有部分作者會(huì)承認(rèn)的確使用了,但并未聲明。

表示:「本質(zhì)上,這是一場(chǎng)軍備競(jìng)賽。就看騙子和偵探誰(shuí)能勝出了。」

學(xué)術(shù)界要被攻陷了!

總之,形勢(shì)已經(jīng)很嚴(yán)峻。

Bik已辭去工作,成為大眾知名的專業(yè)打假人

舊金山的一位微生物學(xué)家、獨(dú)立研究誠(chéng)信顧問(wèn) Bik表示,和其他生成式AI工具的迅猛崛起,為「論文工廠」提供了充足的彈藥。

這是一條完善的產(chǎn)業(yè)鏈:這些公司大量生產(chǎn)和炮制出虛假的論文,賣給急需提高學(xué)術(shù)成果產(chǎn)量的研究者。

Bik說(shuō),現(xiàn)在問(wèn)題已經(jīng)惡化了一百倍。

如今的學(xué)術(shù)圈,可能已經(jīng)充斥著一大批AI生產(chǎn)的「垃圾」論文。我們根本無(wú)從分辨,哪些是經(jīng)過(guò)認(rèn)真研究產(chǎn)生的嚴(yán)肅學(xué)術(shù)成果,哪些是AI炮制出來(lái)濫竽充數(shù)的「垃圾」。

同行評(píng)審:時(shí)間緊,人不夠

那么問(wèn)題來(lái)了,為什么那些由AI生成的假論文,能屢次通過(guò)如此嚴(yán)格的同行評(píng)審?

一方面,這類的技術(shù)還比較新,并不是所有人都能有效辨別;另一方面,同行評(píng)審可能根本沒(méi)有時(shí)間來(lái)檢查這個(gè)問(wèn)題。

對(duì)此,化名「 」去揭發(fā)偽造論文的 表示,期刊中那些由LLM生成且未被發(fā)現(xiàn)的論文,指向了一個(gè)更深層次的問(wèn)題:同行評(píng)審?fù)銐蚨嗟臎](méi)有時(shí)間,來(lái)徹底檢查稿件中的可疑之處。

「畢竟,整個(gè)科學(xué)界的態(tài)度就是『要么發(fā)表,要么死亡( or )』」,說(shuō),「因此『守門人』的數(shù)量永遠(yuǎn)都不是夠的。」

也許,這就是當(dāng)前殘酷的現(xiàn)實(shí):評(píng)審論文需要大量的時(shí)間和專業(yè)知識(shí)chatgpt幫忙看論文,但AI只需幾分鐘就能完成一篇,無(wú)論它的質(zhì)量是多差。

聲明:本站所有文章資源內(nèi)容,如無(wú)特殊說(shuō)明或標(biāo)注,均為采集網(wǎng)絡(luò)資源。如若本站內(nèi)容侵犯了原著者的合法權(quán)益,可聯(lián)系本站刪除。